大模型2.0时代:爆火的Sora,改变了什么?

与去年ChatGPT爆火带来的文本生成相同,今年Sora的出现,让全球再次看到了AIGC的巨大威力。从1月底的万兴“天幕”大模型再到Sora,大模型正在从图文1.0时代,加速进入到以音视频多媒体为载体的2.0时代。

Sora的强势表现,掀起了行业热议。这厢谷歌用自家AI新品“打假”Sora,那边特斯拉CEO马斯克则直接表示人类愿赌服输(gg humans),更有不少专业人士直接对Sora的技术报告“开挖”。

众说纷纭下,不可否认的是,Sora确实带来了视频生成的全新可能性与震撼感。业界不乏有人用“史诗级”、“现实不存在了”等来形容Sora的“炸裂”,并总结出以下五大提升之处:

1.一键生成60秒视频:只需一段文本,Sora就可以生成长达60秒的视频。

2.复杂场景和角色生成能力:Sora生成的视频在内容丰富度、质量精美度、镜头多样度等方面有质的飞跃。

3.多镜头生成能力:Sora可以在单个生成的视频中创建多个镜头,同时保持角色和视觉风格的一致性。

4.三维空间的连贯性和物体持久性Sora能够生成具有动态相机运动的视频。在相机移动和旋转时,Sora能够保持人物和场景元素的连贯运动,并确保在整个视频中物体的外观一致。

5.与世界的互动:Sora有时能模拟出简单的物理行为。例如,画家在画布上留下笔触,或者某人吃汉堡留下咬痕。

“炸裂”表现只是表象,透过OpenAI发布的技术报告,以下三大特点或许是Sora出圈的关键:

大力出奇迹

众所周知,去年引发第一波AI浪潮的ChatGPT,是OpenAI“大力出奇迹”的范式。大量数据的训练会让大模型产生“涌现”的能力,这让ChatGPT能够拥有更好的语言表达能力以及逻辑能力。

这次Sora显然是另一个“大力出奇迹”的范本。据相关人士推测,此次Sora的训练参数量约30亿。这个数字看似与GPT-4的1.8万亿相差甚远,但对于视频类模型训练来说,Sora已经是名副其实的“大”模型。

相比起“随处可得”的文本数据,原始视频的数据量就已“输在起跑线上”,更不用说在Sora之前,大部分模型都需要将原始视频进行统一格式的裁剪,以便于训练。

视频数据有各种各样的形式,有横屏的,有竖屏的,有4k高清的电影,也有64*64的马赛克图片。统一格式,意味着很多非目标格式的视频,都会面临大多数画面被浪费的窘境。

为了解决各类视频分辨率、格式不一,难以统一进行学习的问题,OpenAI设计了一种叫做“spacetime patches”的分解方式,将视频分解成统一格式的小模块,以最大化利用所有视频数据。

Spacetime patches究竟是什么呢?我们可以从patch入手来理解。

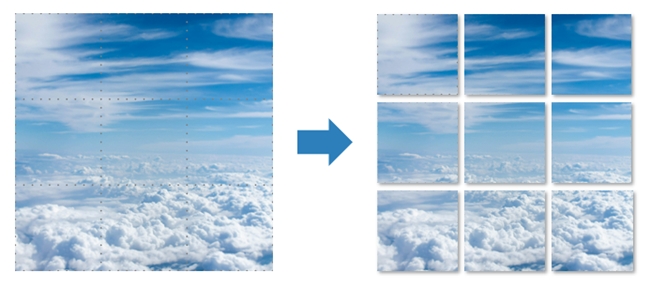

Patch可以理解为一张图片的其中一小块截图。假设现在有一张9×9分辨率的图片,设定每一个patch是一个3×3分辨率的小碎片,那么这张图片就可以被分割成为9个patches,他们各自相邻,组合在一起就能够复原出一张完整的图片。

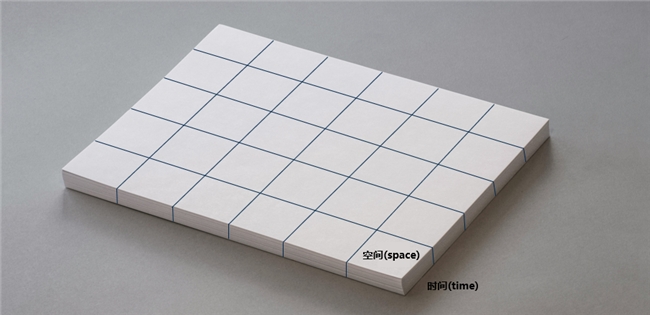

而spacetime patches,则是将一个视频按照这个原理进行分割。众所周知,视频本质上是随时间变化的一系列图像(也就是帧)。如果将视频中每一帧都看做一页A4纸,那么随着时间轴的不断推进,可以分解出很多很多页“纸”。将这些“纸”按照顺序摞在一起,这摞“纸”就有了一定的高度,而这个“高度”实际上就是时间轴。

现在,如果想要将视频也分解成一个个patch,其实类似于直接将这摞“纸”按照一定规格大小切开——我们就得到了一小摞一小摞的“纸”。每一小摞“纸”的“高度”依旧是视频的时间轴,而每一页则是每一帧画面中的一小部分。

由此,这些小纸堆既包含了每一帧画面中的一部分信息,还包含了这个固定位置的画面如何随着时间流逝而产生变化的信息。这就是spacetime patches,它们代表了视频数据的两个最重要的维度——空间和时间。

通过采用spacetime patches的模式来对视频进行最大程度的分解与训练,Sora为行业提供了一个将视频数据“物尽其用”的方法,对于数据需求量巨大的视频生成行业来说,这显然是个好消息。

现在,万事俱备,只待训练了。

特集众家之“大成”

刚才介绍了OpenAI如何把完整的一个视频,遵循一定逻辑转化成能够投入训练的“原材料”。那么,原料已备齐,这次的“厨师”又有什么过人之处呢?

与市面上大部分视频生成类大模型不同,Sora采用了一个比较特别的“厨师”——Diffusion Transformer(DiT)模型。

DiT结合了Diffusion(扩散模型)和Transformer两大目前AI行业最火模型的原理结构,集两者之大成,真正让Sora生成的视频能够流畅。

其中,Diffusion是目前市面上最主流的图片生成模型,通过对输入的图片打上噪点(可以理解为一种马赛克),再根据全是噪点的图片来反推原图,来学习图片生成。

Diffusion在生成单张图片时效果还是很不错的。但问题在于,对于视频生成领域来说,算法需要生成连续数帧图像、保障每一帧图像都能够与前后帧丝滑地连续变化,同时整体的变化过程还需要符合逻辑。

如果单纯使用Diffusion来生成视频,那么随着视频时间变长,算法无法保障当前画面和5秒、10秒以后的画面是否还能够符合变化逻辑。

为了解决这一问题,OpenAI引入了Transformer来增强算法对于生成内容的整体掌控能力。

作为GPT系列的底层模型,Transformer在提升内容整体的完整度上有自己的独门绝技——那就是它的自注意力机制。自注意力机制能够让大模型在训练的时候,不仅学习当下这个单词的编码,更能够同时学习到这个单词周围的其他单词、它们之间是什么关系。

在NLP里,自注意力机制能够让GPT学会每一个单词和周围单词之间的关系、更深层次地理解了一个句子的构成逻辑。

放在视频生成中,Transformer的自注意力机制则能够帮助机器学习到每一个patch之间的关系——不论是空间上的,还是时间上的关系。正如GPT理解了句子的构成逻辑一样,Sora也理解了一个画面随着时间流逝而变化的逻辑。

由此,一个能够让生成的视频内容更稳定、更符合现实逻辑的视频生成算法就炼成了,而DiT在Sora中的优越表现,也为行业带来了“另辟蹊径”的解题思路。

让大模型更能“听得懂话”

除了图像/视频的数据处理与训练,语言理解仍然是用户与大模型交互的最主要途径。这意味着,Sora不仅需要会生成视频,还需要会根据文字指令来生成符合要求的视频。

OpenAI又是怎么让Sora能够更好理解文字指令的呢?

OpenAI采用了此前已在DALL·E 3中使用的re-captioning技术,通过训练一个用于详细描述视频内容的文本模型,来对所有投入训练的视频素材进行详细的文字描述。

这个专门的文本模型会对包括视频的主要内容、角色运动、镜头运动、环境、背景、细节、风格等等内容进行总结。通过模板化的方式进行系统的描述,Sora可以清晰地了解到每段视频的具体内容。

这部分文本描述内容可以在最终训练的时候与前面提到的时空图像块进行匹配和训练。最终,AI就可以理解和对应上文本描述与视频时空图像块。

此外,OpenAI还使用了GPT,把用户的简短提示词转化成详尽的说明,生成更便于Sora理解的prompt。也就是说,用户的简单的描述会被转化为与训练时类似的详细描述语句。这有助于Sora准确理解用户的需求。

视频行业迎来新春天

Sora的横空出世,显然将会给视频领域带来诸多变化,也将为所有做视频模型的企业指出优化路径,加速提升大模型在视频创作和视频创意生成方面的赋能能力,并扩展“音视频+大模型”的应用空间。

正如AIGC软件A股上市公司万兴科技(300624.SZ)董事长吴太兵此前指出的,大模型正从图文1.0时代,加速进入到以音视频多媒体为载体的2.0时代,从模型到应用场景对用户一条龙赋能,将成为主流发展趋势。

当前,包括万兴科技在内的公司,都在积极布局大模型。年初,万兴科技推出万兴“天幕”音视频大模型,聚焦数字创意垂类创作场景,基于15亿用户行为及100亿本土化高质量音视频数据沉淀,以音视频生成式AI技术为基础,全链条赋能全球创作者,致力于让大模型应用落地更有针对性、更具实效。

目前,万兴“天幕”众多能力已在万兴科技旗下创意软件产品中规模化商用。其中,视频创意产品Wondershare Filmora 13、一站式出海视频营销神器万兴播爆均已实现大模型能力的落地应用。

依托万兴“天幕”大模型能力,万兴科技正加速重塑“创意软件”,推动旗下产品全面智能化,不断降低大模型使用门槛,让大模型更好地赋能全球新生代创作者。